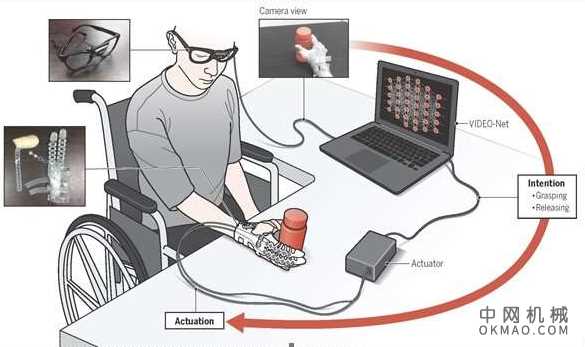

韩国的研究小组为可穿戴手机器人提出了一种新的范例,它可以帮助手部行动不便的人。手动机器人使用机器学习算法收集用户行为,以确定用户的意图。

Sungho Jo教授(KAIST)和Kyu-Jin Cho(首尔国立大学)提出了一种新的可穿戴手机器人意图检测范例中国机械网okmao.com。提出的范例可根据用户行为预测抓握/释放意图,从而使手部行动不便的脊髓损伤(SCI)患者能够拾取和放置物体。

他们开发了一种基于机器学习算法的方法,该算法可通过第一人称视角的相机预测用户的意图。他们的发展基于这样的假设,即可以通过收集用户手臂行为和手-对象交互来推断用户意图。

基于此假设,设计了本研究中使用的机器学习模型,即以EgOcentric视角为基础的基于视觉的意图检测网络(VIDEO-Net)。VIDEO-Net由识别用户手臂行为的空间和时间子网络,以及识别手-物体交互的空间子网络组成。

一名戴着Exo-Glove Poly II(可穿戴软手机器人)的SCI患者在没有任何其他帮助的情况下成功地拾起并放置了各种物体,并进行了日常生活中的基本活动,例如喝咖啡。

该改进的优点在于,它无需任何人对人的校准或其他动作即可检测用户意图。这使人类能够无缝地使用可穿戴手机器人。

一个韩国研究小组创造了一种可穿戴的手形机器人,该机器人可以帮助失去行动能力的残疾人。

机器人可以通过机器学习算法收集行为,从而检测用户的意图。图片提供:首尔国立大学软机器人研究中心

曹圭仁教授访谈

问:此系统如何工作?

答:这项技术旨在通过利用安装在眼镜上的第一人称视角的相机来预测用户的意图,特别是对目标物体的抓握和释放意图。VIDEONet是一种基于深度学习的算法,旨在根据用户手臂的行为和手-物体之间的交互来预测摄像机的用户意图。

我们没有使用通常用于检测残疾人意图的生物信号,而是使用一个简单的摄像头来查找该人是否在试图抓住它。之所以可行,是因为目标用户可以移动手臂,但不能移动手。通过观察手臂的运动以及与物体和手的距离,并使用机器学习来解释观察结果,可以预测用户的抓握意图。

问:谁从这项技术中受益?

答:如前所述,该技术可从人的手臂行为和手与物体的交互来检测用户的意图。任何因脊髓损伤,中风,脑瘫或任何其他状况而导致手部行动不便的人都可以使用此技术,只要他们可以自愿移动手臂即可。

问:局限性和未来的作用是什么?

答:大多数限制来自使用单眼相机的缺点。例如,如果目标对象被另一个对象遮挡,则该技术的性能会降低。另外,如果在相机场景中看不到用户手势,则该技术将不可用。为了克服由于这些问题而导致的通用性不足,需要通过合并其他传感器信息或其他现有的意图检测方法(例如使用肌电图传感器或眼动追踪)来改进算法。

问:要在日常生活中使用此技术,您需要什么?

答:为了使这项技术在日常生活中得到使用,用户需要具有可操作模块,计算设备和安装了摄像头的眼镜的可穿戴手机器人。我们的目标是减小计算设备的尺寸和重量,以便使机器人可以携带起来以在日常生活中使用。我们使用了满足我们要求的紧凑型计算设备,但我们希望能够执行深度学习计算的神经形态芯片将在市场上出售。